近期,科技界传来了一则关于多模态AI技术的新突破。据报道,苹果公司与法国索邦大学联手,在多模态AI模型的训练与优化方面取得了显著成果。他们对比了早期融合与后期融合两种模型,并揭示了早期融合模型在计算效率和扩展性方面的独特优势。

多模态AI技术旨在同时处理多种数据类型,如图像和文本,以实现更全面的信息理解和应用。然而,这一技术面临的一个主要挑战是如何有效地整合这些异构数据。目前,多数多模态AI系统采用的是后期融合策略,即分别训练视觉编码器、语言模型等单模态模型,然后再进行组合。这种方法虽然操作简便,但难以实现真正的多模态理解和协同。

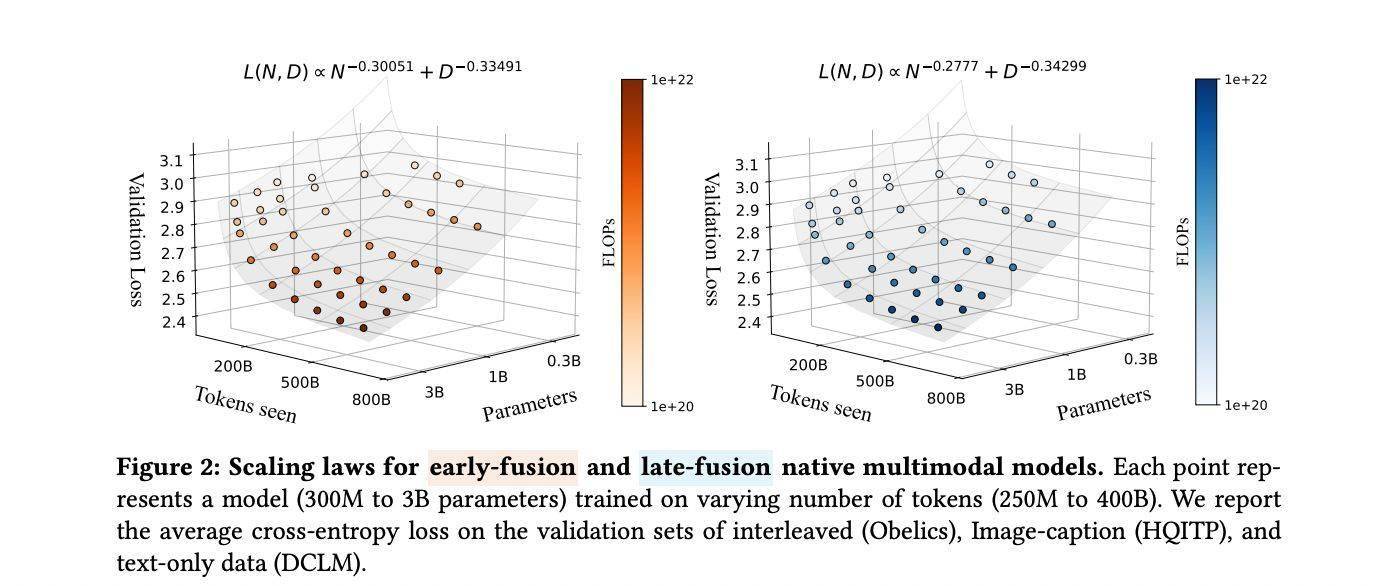

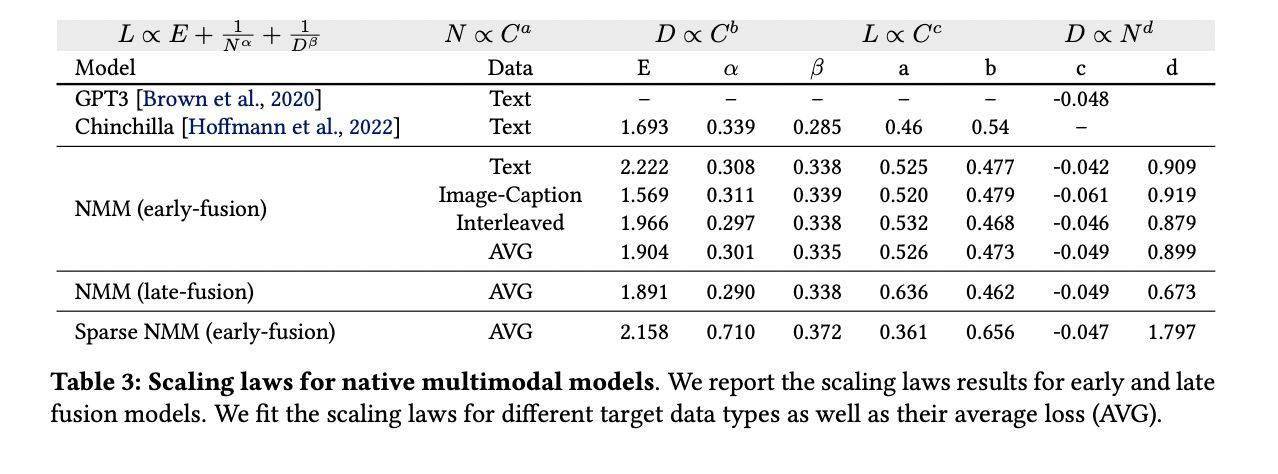

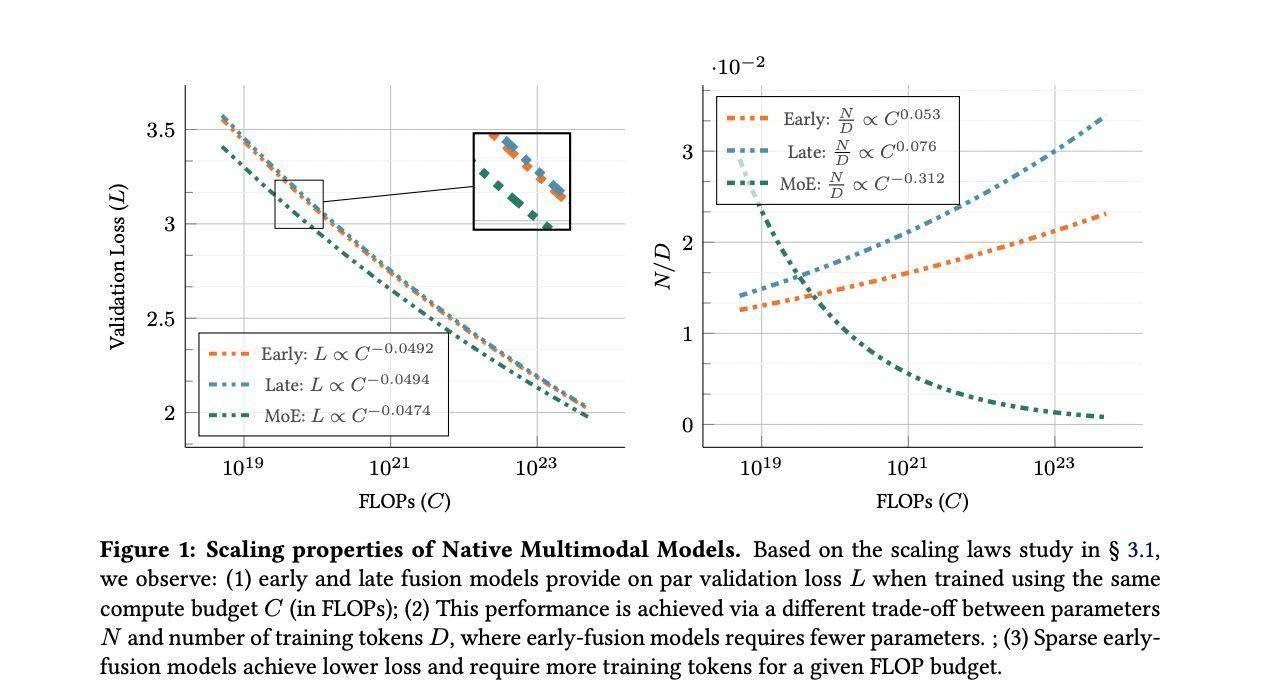

苹果与索邦大学的联合团队对这一传统策略提出了挑战。他们深入研究了从头训练的原生多模态模型(NMMs)的扩展特性,并对比了早期融合与后期融合模型的表现。实验结果显示,在从头训练的情况下,早期融合模型与后期融合模型在性能上相当,但早期融合模型在计算资源有限的情况下更为高效,且易于扩展。

研究团队还探索了专家混合(MoE)稀疏架构在多模态模型中的应用。他们发现,稀疏架构能够动态地分配参数,针对不同模态进行专项优化。与稠密模型相比,稀疏模型在性能上有显著提升,特别是在小规模模型中表现尤为突出。这一发现进一步证明了稀疏架构在多模态AI技术中的潜力。

研究团队通过系统实验,训练了从0.3亿到40亿活跃参数的多模态模型,以验证早期融合和稀疏架构的实际效果。实验结果表明,原生多模态模型的扩展规律与语言模型相似,但跨模态数据类型和训练组合会对扩展系数产生一定影响。稀疏模型在等效推理成本下持续优于密集模型,展现出了处理异构数据的强大能力。

稀疏模型在扩展过程中更倾向于优先增加训练数据量而非活跃参数数量,这与稠密模型的扩展模式截然不同。这一发现为进一步优化多模态AI模型的性能和扩展性提供了新的思路。

此次研究不仅挑战了多模态AI技术的传统设计理念,还为未来高效多模态AI系统的开发提供了重要方向。统一早期融合架构与动态参数分配的结合,有望成为推动多模态AI技术发展的新动力。